ollama安裝包純凈版是一款能在本地部署大語言模型的工具,由Ollama團隊開發,不是Facebook那家公司做的。它內置了不少模型,像Llama、DeepSeek這些都能用,也能導入本地模型文件,不過得先寫個配置文件,不能直接拖進去。操作起來也非常的簡單,按步驟操作就行,適合想自己鼓搗大模型的小伙伴。

ollama安裝包純凈版安裝教程

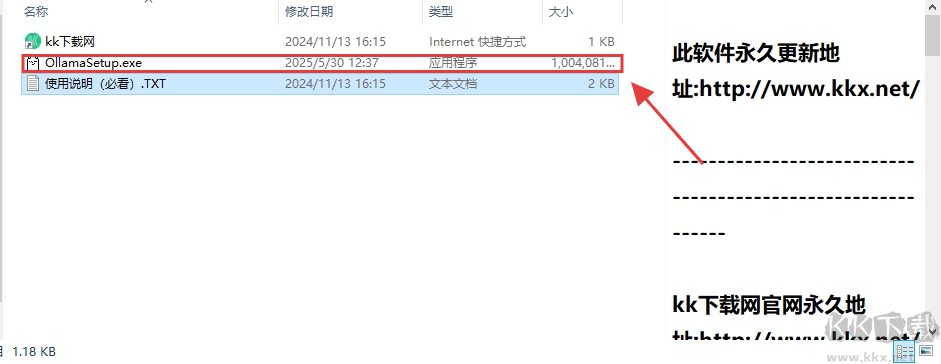

1、解壓安裝包后,找到并運行 ollamasetup.exe 程序。

2、彈出安全警告窗口時,點擊 “運行” 繼續安裝。

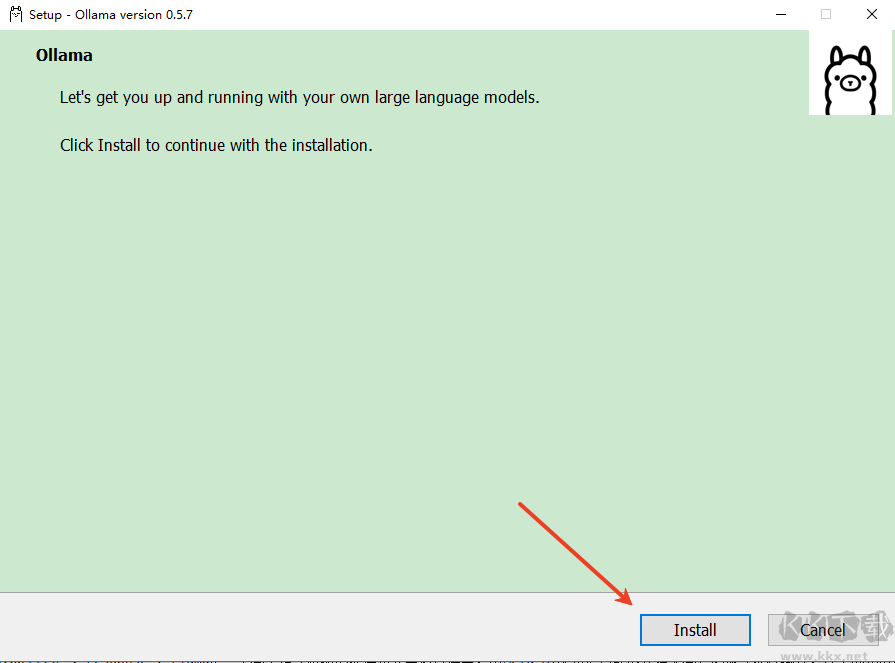

3、進入安裝界面,點擊 “install” 按鈕,等待片刻完成安裝。

ollama 安裝包純凈版本地部署教程

1、若搭配 DeepSeek 模型,根據電腦配置選版本(如 1.5b、7b 等,版本越高對 GPU 要求越高)。

2、復制對應版本安裝命令(例:DeepSeek-R1-Distill-Qwen-1.5B 對應 ollama run deepseek-r1:1.5b)。

3、打開 CMD 命令框,輸入命令(如 ollama run deepseek-r1:1.5b),自動在線部署。

4、部署成功后,可在命令窗口輸入問題與模型交互。

ollama 安裝包純凈版功能

API 與多語言支持

1、REST API:兼容 OpenAI 接口,通過 /api/generate 和 /api/chat 生成文本或對話。

2、客戶端集成:支持 Python、Java、C# 等語言調用,便于集成至 Web 或桌面應用。

硬件加速與資源優化

1、GPU 加速:在支持 CUDA 或 Metal 的設備上,利用 GPU 提升推理速度。

2、資源管理:通過環境變量(如 OLLAMA_KEEP_ALIVE、OLLAMA_MAX_VRAM)優化內存和顯存占用。

本地化部署

1、支持 macOS、Linux 和 Windows(預覽版),可通過 Docker 或安裝包部署,保障數據隱私與低延遲。

模型管理便捷

1、模型倉庫:提供 Llama3、Phi3、Gemma2 等預構建模型,通過 ollama pull 快速下載。

2、自定義模型:通過 Modelfile 定義參數(如溫度值、系統提示),創建個性化模型(如指定角色回答)。

3、多模型并行:支持同時加載多個模型,調整 num_ctx 控制上下文長度。

ollama 安裝包純凈版本地部署配置要求

硬件要求

1、內存:最低 8GB,推薦 16GB 及以上。

2、顯卡:支持 NVIDIA(30/40 系列)或 AMD(T4、V100、A10 等),顯存至少 8GB。

3、處理器:最低 8 核,推薦 16 核及以上。

4、存儲:至少 100GB 可用空間。

軟件依賴

1、Docker(部分功能需支持)。

2、Python(用于高級開發)。

ollama 安裝包純凈版應用場景

1、企業知識庫與 RAG 應用:結合檢索增強生成技術,本地處理敏感數據(如通過 Ollama RAG Chatbot 與本地 PDF 交互)。

2、多模態與代碼生成:支持 LLaVA 分析圖像,或通過 CodeLlama 生成代碼片段。

3、本地對話與開發測試:通過命令行(如 ollama run llama3)或 Web 客戶端(LobeChat、OpenWebUI)實現可視化交互。

ollama安裝包純凈版 v0.9.0 979.9MB

ollama安裝包純凈版 v0.9.0 979.9MB